10 herramientas para evaluar intervenciones de salud digital

Con la llegada de la salud digital, se añade una dimensión en las intervenciones de salud, que se refiere a la tecnología, y cómo las personas interactuarán con ella y si la aceptarán o no, así como su influencia en los resultados de la intervención. En búsqueda de las mejores prácticas se empiezan a hacer revisiones sistemáticas para dar con los mejores modelos.

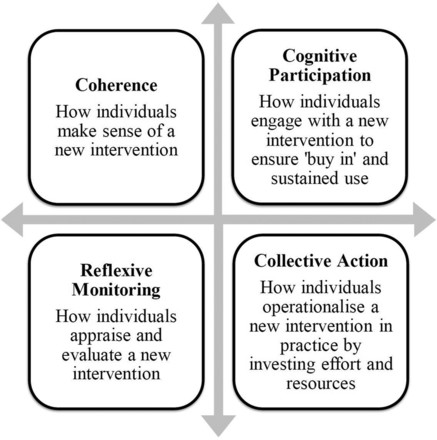

La Teoría de Normalización del Proceso para analizar intervenciones de eSalud

El British Journal of Medicine Open publica un protocolo, mediante el cual, un grupo de investigadores británicos se propone hacer una revisión sistemática de investigaciones cualitativas, sobre los factores determinantes en el compromiso de pacientes y público en intervenciones de eSalud

Para la revisión se incorporan dos teorías sociológicas fundamento empírico, la Teoría del Proceso de Normalización (NPT) y la teoría de la carga del tratamiento BOTT (burden of treatment theory). La revisión sistemática de los estudios cualitativos tendrá como objetivo identificar y sintetizar los conocimientos actuales acerca de las barreras y los elementos facilitadores para enrolar participantes, a través del análisis de una serie de intervenciones de salud, brechas digitales y los aspectos más destacados del conocimiento y posibles áreas para futuras investigaciones. Además, los marcos teóricos ya se han utilizado previamente para ayudar a muchos tipos de síntesis cualitativa, como modelos establecidos que pueden ayudar a explicar el fenómeno en cuestión y hacer que los resultados del estudio hagan más accesible la aplicación práctica. Es por tanto interesante conocer las bases de la NPT.

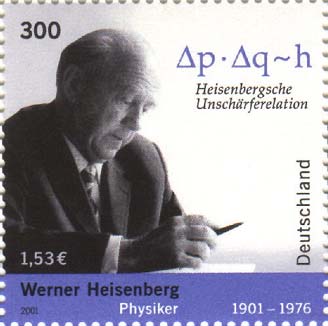

El principio de incertidumbre en la evaluación de Apps de salud

El principio de incertidumbre desarrollado por Heisenberg (1927), postula que es imposible conocer conjuntamente con exactitud, la posición y la velocidad de una partícula sub-atómica (en la llamada mecánica cuántica). Cuanto mayor sea la precisión con que determinamos la posición, menor será la de su velocidad.

El principio de incertidumbre desarrollado por Heisenberg (1927), postula que es imposible conocer conjuntamente con exactitud, la posición y la velocidad de una partícula sub-atómica (en la llamada mecánica cuántica). Cuanto mayor sea la precisión con que determinamos la posición, menor será la de su velocidad.

Podríamos decir que sucede lo mismo en la evaluación de Apps de salud, si se valora exhaustivamente la App, como lo hacen los organismos acreditadores, ganamos en precisión, pero perdemos velocidad (y por tanto alcance); mientras que si valoramos mediante un sistema rápido, como la aplicación de la escala iSYScore, la valoración se puede efectuar más rápida, pero en la dimensión de seguridad, los acreditadores siempre serán los determinantes.

Big data, una oportunidad en salud

El manejo de grandes volúmenes de datos no es nuevo. La gran mayoría de las empresas e instituciones ya llevan mucho tiempo trabajando con muchos datos, y los estudian con elementos como los llamados DataWarehouses, con potentes herramientas analíticas que les permiten tratar de forma adecuada esos grandes volúmenes. Entonces ¿cuál es la diferencia? ¿porqué ahora todo el mundo habla de big data?

La evolución de la tecnología y los menores costes del almacenamiento han hecho que los volúmenes manejados por las aplicaciones hayan aumentado de manera muy importante. La eclosión de los teléfonos móviles, los sensores, el GPS, la iOT y la digitalización progresiva de muchísimas actividades, genera un volumen de datos a una velocidad incomparable y de forma menos estructurada a los usos anteriores.